GPT-4Vとは?ChatGPTの新機能GPT-4Vでできることや利用用途について

Fotographer AI, Inc.

Latest Update :

November 11, 2023

常に話題性に事欠かないAIですが、AIは常に進化し続けており凄まじいスピードで活用の幅を増やしています。

本記事では、直近のAIの火付け役でもあるChatGPTの最新AIモデルであるGPT-4Vについて、これまでのChatGPTに搭載されていたAIモデルとの違いや、GPT-4Vができること、利用用途などをご紹介します。

GPT-4Vとは

出典:https://openai.com/research/gpt-4v-system-card

GPT-4Vとは、OpenAI社から2023年10月中旬ごろにリリースされた最新のマルチモーダルAIモデルです。

※マルチモーダルとは、テキスト・画像・数値・音声など複数のデータ種別(モダリティー)を組み合わせて、もしくは関連づけて処理できるAIモデルのことを指します。

ChatGPTにも搭載されており、ChatGPTplusという有料版を利用されているユーザーは、既にGPT-4Vを使うことができます。

詳細は後ほど記載しますが、「遂にGPTは人の " 目 " と " 耳 ” と " 口 " を手に入れた」などとも言われており、ただの自動回答AIから、より人々の生活のサポート役としての存在感を強めています。

ChatGPTが世に登場してから、その利便性やこれまでのAIとの性能の差分から、広く世間には認知されてきました。GPT-4VとこれまでのGPTとの違いについて下記で説明していきます。

GPT-4Vを含む直近の各verとの違い

GPT-3.5とGPT-4の違い

まずはGPT‐3.5とGPT-4の違いについてです。

全体感としては、AIモデルそのものの性能に大きな開きがあります。

具体的には以下の点です。

1. GPT-3.5は無料版でも利用可能、GPT-4は有料版のみ提供

よくある話ですが、GPT-3.5はGPT-4と比較して性能面で劣るため無料ユーザーでも利用可能な一方で、GPT-4は有料版ユーザーのみ利用可能でした。ここはAIとしての差分というよりは、単純に販売の仕組みの差にはなりますが前提として記載します。

2. GPT-3.5はテキストのみ入力可能、GPT-4は(技術的には)画像や音声などのデータも入力可能

GPT-4は、実際に利用する上ではテキストしか入力することはできませんでしたが、技術的には画像や音声などのデータも取り扱うことができるとされていました。

上記のことを既に知っている方からすると、このGPT-4Vで待ちに待った機能が実装されたと歓喜されているかと思います。

その名の通り、GPT-4の進化verとも捉えることができます。

3. 出力精度が高い

3つ目は、単純に出力されるデータや情報についての精度の差です。

GPT-4の方がGPT-3.5と比較して誤字脱字が減ったり、複数の指示を含む応用的なプロンプトにも対応でき、正確な回答を得ることができます。

以上のように、GPT-3.5とGPT-4Vの間でも性能差が生じていました。

次に、直近のGPT-4とGPT-4Vの違いについて触れていきます。

GPT4とGPT-4Vの違い

先ほど、GPT-4VはGPT-4の進化verであるとお伝えましたが、その成長幅は雲泥の差があるといっても過言ではないでしょう。

これまではテキストデータでの入力しか実装されていなかったものが、GPT-4Vからは画像や音声データも入力可能なだけでなく、それらを混合した処理も可能になりました。

いわゆる一問一答形式ではなく、複合的なデータ種別を混ぜ込んだ受け答えができることでよりリアルな対話のような経験ができるように近づいたと言えることからも、マルチモーダルAIとしての完成度の違いが伺えます。

具体的な差分についてみてみましょう。

1. GPT-4Vを利用できるのは、引き続き有料版ユーザーのみ

現状は、GPT-4同様にGPT-4Vを利用可能なのは、有料版ユーザーのみとなっています。

今後、GPT-5のように更にアップデートされたAIモデルが誕生した際には無料ユーザーでもできる可能性もあるかもしれませんが、少なくとも現状は有料版ユーザーのみ利用可能です。

2. GPT-4Vは、GPT-4の約2倍の性能

GPT-4Vは、GPT-4と比べて、約2倍の性能を誇っています。

具体的な数値で表すと、以下のような差があります。

・GPT-4:約1000億個のパラメータを持つ言語モデル、コンテキスト・サイズ*¹ :約3000単語、コンテキスト・ウィンドウ*² 約1000単語

・GPT-4V:約2000億個のパラメータを持つマルチモーダル言語モデル、コンテキスト・サイズ:約5000単語、コンテキスト・ウィンドウ約2000単語

*1 コンテキスト・サイズ:AIモデルが一度に処理できる入力の長さ

*2 コンテキスト・ウィンドウ:AIモデルが記憶可能な過去の入力の長さ

3. マルチモーダルAIとしての完成度の差

3つ目は、マルチモーダルAIとしての完成度の差です。

上述したようにGPT-4はテキスト入力しか実装されていませんでしたが、GPT-4Vでは画像のみの入力はもちろん、画像とテキストの混合入力にも対応しています。

なので、例えば画像に映っているモノや人物の説明、画像に関連する質問への回答も可能です。

このように見てみると、今回のアップデートによってどれだけ大きな成長を果たしたのかが一目瞭然かと思います。

次に、改めてGPT-4Vができることについて整理をします。

GPT-4Vができること

ここまでGPT-4Vがどういうものかや、これまでのGPTシリーズとの差分について紹介してきましたが、GPT-4Vができることについて、5つほど解説していきます。

画像データの読み込み

1つ目は、画像データの読み込みです。

先述したように、GPT-4までのようにテキストだけではなく画像データを入力することで、AIがそのデータを解析した上で与えられたタスクを処理することができます。

画像データについての言語化

2つ目は、画像データについての言語化です。

まさに画像データと言語の組み合わせとも言える部分ですが、例えば有名なアニメの1シーンを切り取った画像を入力し、「その画像について解説して」というようなプロンプト入力をすることで、そのアニメについての概要をテキストで回答することなどができます。

それ以外にも画像に映る場所を特定したり、文字や記号が含まれる画像データに基づいた推論をすることもできます。

後ほどの利用用途で一部紹介しますが、仕事・プライベートの両面での活用が期待されている機能です。

音声データの読み込み

3つ目は、音声データの読み込みです。

音声データを活用した体験も後述しますが、テキスト・画像だけではなく音声データの入力も可能となりました。

入力されたテキストデータの音声読み上げ

4つ目は、入力されたテキストデータの音声読み上げです。

現状は日本語対応は実装されていませんが、「日本語での文章入力→英語に翻訳→読み上げ」というプロセスを経ることで、英会話スキルが乏しい方であっても簡単に英語で会話できるようになるなど、特にコミュニケーションの面で活用が期待されています。

音声を活用したAIとの対話

5つ目は、音声を活用したAIとの対話です。

こちらはスマホアプリでのみ使用可能な機能ですが、ChatGPTと音声で会話できるようになっています。

イメージとしては、iPhoneに搭載されているSiriとの会話などに近いと思います。

また、音声は5種類の中から選ぶことができます。

このように、従来のGPTシリーズに加えて非常に活用の幅が広がっているGPT-4Vですが不得意なことについても下記に記載いたします。

GPT-4Vが不得意なこと

類似した画像データの識別

まず1つ目は、類似した画像データの識別です。

間違い探しのようなものをイメージして頂くと、わかりやすいと思います。

複数の画像データを読み込み、それぞれの画像同士を比較して相違点を検出するということについては、一定の精度ではできるものの改善の余地があるとされています。

これが人が見てやるのと同じクオリティでできるようになれば、製造業の外観検査業務の効率化(自動化)など非常に多くの場面で活躍ができそうです。

現状、上記のような取り組みに対しては膨大なエンジニアのリソースをかけてプログラムを組み込むなどのことをしていますが、GPTがそうしたプログラムのコーディング等を代替できる日が来るかもしれません。

2023年以降に関する情報に基づいた処理

2つ目は、2023年以降に関する情報に基づいた処理です。

GPT-4Vは、2022年までの情報を基にしていますので2023年以降の情報でしか処理できないタスクについては苦手傾向にあります。

とはいえ、この点についてはさほど大きな問題ではなく時間の経過とともに解決されていくことかと思いますので、あくまでも「現状は」という捉え方で問題ないかと思います。

専門領域に特化したノウハウや知識を要する処理

3つ目は、専門領域に特化したノウハウや知識を要する処理です。

これはGPT-4Vに限った話ではないですが、参照する情報に属人的なノウハウやスキルが絡んでくるものについては、未だに不得意な領域になっています。

例えば、医療現場でいえば撮影されたレントゲン写真から病状や現在の状況を診断したり、営業活動でいえば商談中に相手の発言内容に合わせてどんな質問や言及をすべきかといったことが、該当するかと思います。

よく人類 vs AIについての論争が世間でなされていますが、こうした人でしか担えない部分が残されている限りは、AIにすべてを取って代わられると言い切るのは難しいのではないでしょうか。

複雑な画像解析

4つ目は、複雑な画像解析です。

画像解析そのものについてはGPT-4Vも処理可能ですが、例えば人やモノが非常に多く映りこんでいるような画像については、処理に時間がかかったり、仮に処理できたとしてもその精度が低下する傾向があるそうです。

さて、ここまでGPT-4Vの得意・不得意について解説してきましたので、次は具体的にどんなことに利用できるのかということについて、いくつか例を見てみましょう。

GPT-4Vの利用用途5選

図表を読み取り、考察に必要な情報を提供してもらう

1つ目は、図表を読み取り、考察に必要な情報を提供をしてもらうことです。

日本の各省庁が発表しているような統計情報はもちろん、特に海外論文などで掲載されている図表や統計結果を読み込むときなどに非常に役立てることができると思います。

日本国内のみならず海外論文などの情報からどれだけの考察や示唆を得ることができるのかというのは、ビジネスにおいても生活においても重要視されている昨今の状況かと思いますが、やはり英文や専門用語の読解力がハードルになることが多いものです。

このような際に、GPT-4Vを活用すれば誰でも等しく必要な情報を得ることができます。

GPT-4Vは、情報収集能力を飛躍的に高めることができる可能性を秘めており、GPT-4Vの利用用途の中でも、特に実用性の高い利用方法の1つだと思います。

作成したいイメージをもとにサンプルコードを出力する

2つ目は、作成したいイメージをもとにサンプルコードを出力することです。

例えば、作成したいWebページのイメージ画像を作成し、(Chat)GPT-4Vにその画像をアップロード→「HTMLのコードを作成してください」というプロンプトを入力することで、簡単にサンプルコードが出力可能です。

こちらの使い方をマスターできれば、誰でも簡単にWebページを作成できたり、SaaS製品の開発にあたることができるかもしれません。

文字や記号が含まれた画像をもとに算出結果を得る

3つ目は、文字や記号が含まれた画像をもとに算出結果を得ることです。

例えば、学校で課された宿題を写真で撮影→画像アップロード→「回答を作成してください」と打てば、誰でも数学の問題を解くことができるようになる可能性を秘めています。

現状では多量に情報が盛り込まれているような複雑な処理だと、部分的にミスが発見されているとされていますが、比較的単純なものであれば正確な回答ができているとのことです。

先々には、回答を暗記する力はもちろん、それ以上に根本的に数学的な考え方ができるかどうかという力についても、より重要視されていくことでしょう。

食事の画像を活用したカロリーコントロール

4つ目は、食事の画像を活用したカロリーコントロールです。

既に某スマホアプリでも類似した機能は実装されていますが、食べた食事の写真をアップロードしてどれだけカロリーを摂取したのかを算出することにも利用可能です。

最近では、健康やボディメイクの流行もあり、多くの人々の間で利用することができる身近な利用用途の1つだと思います。

画像に映る被写体(物)の位置の特定

5つ目は、画像に映る被写体(物)の位置の特定です。

アップロードされた画像をもとに、それがどこで撮影されたものかを特定することができます。

東京タワーのようにある程度、位置を特定するために分かりやすいものが映りこんでいることが前提になるかと思いますが、観光や旅行の際に役立てられそうです。

GPT-4Vを使うためには?

これまで何度か記載しておりますが、GPT-4Vの利用にあたっては、ChatGPTの有料プランであるChatGPT plusへの申し込みが必須です。

月額料金として、20$/月ほどかかります。実用的に使うイメージが湧く方は是非ご利用を検討されてみてはいかがでしょうか。

GPT-4Vを使う上で注意したい点

必ずしも正しい情報が得られるとは限らない

まず1つ目は、必ずしも正しい情報が得られるとは限らない点です。

こちらはAI全般にいえることですが、あくまでもAIが出力した情報は尤もらしいものをアウトプットしているにすぎませんので、もちろんその内容が誤っているケースもあります。

非常に手軽に使える反面、その情報への信頼性には常に注意することをお勧めします。

著作権や知的財産侵害への恐れ

2つ目は、著作権や知的財産侵害への恐れがある点です。

特にGPT-4Vについては、画像や音声を取り扱うことができるようになった反面、より一層注意が必要となります。

特に業務を含むビジネスの側面で利用される際には、十分にお気をつけください。

現状は、画像生成等のコンテンツ作成まではできない

3つ目は、現状は、画像生成等のコンテンツ作成まではできない点です。

よく生成AIとひとくくりにされると、「画像も作れるんでしょ?」という声も頂きますが、GPT-4Vはあくまでも画像データや音声データを読み込むことができるだけで、そこから新しいコンテンツを作成できるわけではないです。

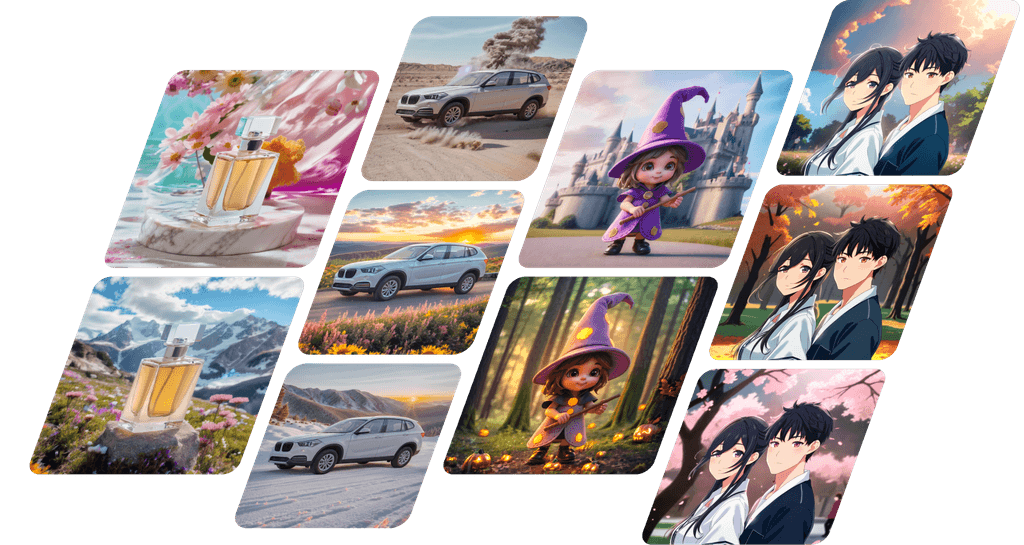

そうした画像や音声・音楽などの生成AIについては、別途適切な生成AIの活用をお勧めします。画像生成をされたい方は、弊社サービス「フォトグラファーAI」もぜひご活用ください。

まとめ

最新のマルチモーダルAIであるGPT-4Vの概要についてご紹介しました。

本記事により、ChatGPTに搭載されていたAIモデルとの違いや、GPT-4Vができること、利用用途などの理解が進み、生成AIの活用の一助になりましたら幸いです。

最後までお読みいただきありがとうございました。